Fragen und antworten

- Ab welchem Alter sollten Kinder einfache Sätze sagen können?

-

Kinder unterscheiden sich in ihren Lernstrategien und im Verlauf ihrer Entwicklung. Darum kann man das Alter, in dem gewisse Entwicklungsstufen erreicht werden (z.B. “mit einem Jahr sprechen Kinder die ersten Worte”), immer nur als allgemeinen Durchschnitt ansehen. Somit ist es völlig normal, wenn Kinder manche Stufen ein paar Monate eher oder später erreichen. Mit diesem Wissen können wir den allgemeinen Entwicklungsverlauf auf dem Weg zu den ersten einfachen Sätzen nachvollziehen.

Die ersten einfachen Sätze sprechen Kinder etwa im Alter von zweieinhalb bis drei Jahren. Das mag sich spät anhören, wenn man bedenkt, dass Kinder bereits mit 12 Monaten die ersten Worte sprechen. Doch bevor sie diese Worte zu Sätzen zusammensetzen können, müssen Kinder ein gewisses Grundwissen über die Grammatik ihrer Sprache erwerben. Oftmals denken wir an Substantive und Verben als die Grundbausteine für Sätze („Katze“ + „wollen“ + „Milch“ = „Die Katze will etwas Milch“). Doch bereits recht einfache Sätze erfordern es, andere Wörter („die“, „etwas“) und flektierte Formen („wollen“ → „will“) einzusetzen. Solche Funktionswörter und Flexionen zu lernen ist nicht einfach, denn im Gegensatz zu Inhaltswörtern wie „Katze“ und „Milch“ können Kinder die Bedeutungen von „die“ und „will“ nicht erfahren oder erleben. Was das Unterfangen noch verkompliziert ist der Umstand, dass die Wörter in die richtige Reihenfolge gebracht werden müssen und laut mit einer Satzmelodie und Betonung ausgesprochen werden müssen, die der angedachten Bedeutung entspricht (man vergleiche „Die KATZE will etwas Milch.“ mit „Die Katze will etwas MILCH.“). All das ist sehr schwierig für junge Kinder, selbst bei recht einfachen Sätzen.

Doch auch wenn Kinder unter zweieinhalb Jahren noch keine ganzen Sätze sagen, lernen sie schon Wörter auf andere Arten zu kombinieren. Beispielsweise beginnen viele Kinder bereits nach ihrem ersten Geburtstag Wörter mit Gesten, wie z.B. auf etwas zeigen und nicken zu verbinden. Die Kombination aus einem Wort und einer Geste, wie z.B. „Milch“ und nicken, sagt mehr als nur das Wort oder nur die Geste allein. Und einige Studien zeigen, dass diese frühen Kombinationen eine Verbindung zur weiteren Entwicklung von Zwei-Wort-Äußerungen ein paar Monate später aufweisen.

Ab etwa 18 Monaten beginnen Kinder Zwei-Wort-Äußerungen wie „Bär. Koffer.“ zu sagen, um satzähnliche Bedeutungen auszudrücken (wie z.B. „Der Bär ist im Koffer.“). Anfangs klingen diese zwei Wörter wie zwei einzelne Äußerungen ohne Verbindung. Aber mit viel Übung werden die Pausen zwischen den Wörtern kürzer und die Melodien der einzelnen Wörter beginnen sich zu verbinden.

Mit zwei Jahren, wenn Kinder vollends in der „Zweiwortphase“ angekommen sind, produzieren sie oft Abfolgen von zwei bis drei Wörtern, die wie normale Sätze klingen, nur dass die meisten Funktionswörter und Flexionen fehlen („Da Katze!“). In dieser Phase ihrer Entwicklung setzen manche Kinder solche Wörter sogar konstant in eine bestimmte Reihenfolge. Beispielsweise setzen manche Kinder sogenannte Schlüsselwörter (engl. pivot words) immer an erste Stelle („mehr Apfel“, „hier Apfel“), andere Kinder immer an zweite Stelle („Apfel mehr“, „Apfel hier“). Mit kürzer werdenden Pausen, konsistenter Reihenfolge der Wörter und einer wortübergreifenden Melodie haben die Äußerungen der Kinder mehr und mehr Eigenschaften von einer einzigen Planungseinheit: einem Satz.

Doch auch wenn Kinder mit zweieinhalb bis drei Jahren die ersten einfachen Sätze sagen, haben sie noch viel zu lernen. Ihr Wissen über die Kombinationsmöglichkeiten von Wörtern ist noch nicht vergleichbar mit dem von Erwachsenen. Stattdessen beschränken sie sich meist noch auf das, was sie am häufigsten hören. Die richtigen Flexionen zu verwenden kann noch lange schwierig bleiben, und es ist nicht ungewöhnlich, dass Kinder auch weiterhin Fehler machen, während sie noch lernen müssen, welche Flexionen regelmäßig (putzen, putze, putzt, putzte) und welche unregelmäßig sind (sein, bin, ist, war). In den nächsten zwei Jahren nach den ersten einfachen Sätzen machen Kinder große Fortschritte im Umfang ihres Wortschatzes und den Flexionen, die sie benutzen. Mit zunehmendem Alter werden ihre Sätze komplizierter, und mit vier bis fünf Jahren haben sie das meiste erlernt, was sie brauchen um flüssig mit anderen zu kommunizieren.

Wenn Sie mehr über Sprachentwicklung erfahren möchten, schauen Sie sich doch einmal die Webseite des Nimwegner Baby & Child Research Center an.

By: Marisa Casillas & Elma Hilbrink

Aus dem Englischen übersetzt von: Matthias Barthel & Sebastian SauppeLiteratur:

Clark, E. V. (2009). “Part II: Constructions and meanings”. In First language acquisition (pp. 149–278). Cambridge University Press.

Iverson, J. M., & Goldin-Meadow, S. (2005). Gesture paves the way for language development. Psychological science, 16(5), 367-371.

- Sprache und Programmieren im Gehirn

-

Siegmund und Kollegen (2014) waren die ersten, die empirisch die Verbindung zwischen Programmieren und anderen kognitiven Domänen wie Sprachverarbeitung untersucht haben - zumindest mit Hirntomographie. Sie verwendeten funktionelle Magnetresonanztomographie (fMRI), die Veränderungen in der lokalen Sauerstoffsättigung des Blutes als Funktion von Hirnaktivität verschiedener Netzwerke von Neuronen misst. Die Gehirne von Informatik-Studenten wurden beobachtet während sie im Tomographen lagen und Code-Ausschnitte lasen und verstehen mussten und während sie ähnlichen Code lasen und nach syntaktischen Fehlern suchen, aber sonst nichts verstehen mussten. Dabei wurde Aktivität in den klassischen Sprachnetzwerken festgestellt: Brocas und Wernickes Areal, vor allem in der linken Hemisphäre.

Der zu lesende Code war so angelegt, dass er das sogenannte bottom-up-Verständnis fördern sollte, also das Lesen und Verstehen von Ausdruck für Ausdruck und Zeile für Zeile. Versuchsteilnehmer sollten also nicht nur einen flüchtigen Blick auf die Gesamtstruktur des Codes werfen. Der bottom-up-Prozess kann mit Prozessen in der Sprachverarbeitung verglichen werden, während denen einzelne Wörter nach syntaktischen Regeln kombiniert werden, um einen zusammenhängenden Satz zu generieren, und diese Sätze dann zu einem Gespräch verknüpft werden. Es gibt zudem Hinweise darauf, dass sprachbegabte Menschen auch die besseren Software-Entwickler sind (Dijkstra 1982). Eine mechanistische Erklärung hierfür könnte die Stärke der Verbindungen zwischen den erwähnten Hirnregionen sein, die sich von Mensch zu Mensch unterscheiden. Zusammenfassend lässt sich sagen, dass die gleichen Netzwerke im Gehirn für Programmieren und Sprache verwendtet werden.

By: Julia Udden, Harald Hammarström and Rick Janssen

Aus dem Englischen übersetzt von Tayo Takada & Sebastian Sauppe

Siegmund, J., Kästner, C., Apel, S., Parnin, C., Bethmann, A., Leich, T., Saake, G. & Brechmann, A. (2014) Understanding Understanding Source Code with Functional Magnetic Resonance Imaging. In Proceedings of the ACM/IEEE International Conference on Software Engineering (ICSE).

Dijkstra. How Do We Tell Truths that Might Hurt? In Selected Writings on Computing: A Personal Perspective, 129–131. Springer, 1982.

- Was haben das Erlernen einer natürlichen Sprache und das Erlernen einer Programmiersprache gemeinsam?

-

Programmiersprachen werden in der Regel Jugendlichen oder Erwachsenen beigebracht - ähnlich wie Fremdsprachen. Diese Art des Lernens nennt man "explizites Lernen". Im Unterschied dazu haben wir alle unsere Muttersprache in frühester Kindheit implizit gelernt. Kindern braucht man nicht explizit beizubringen wie man Sprache benutzt, sie lernen durch Beobachtung und Übung. Eine Grundvoraussetzung, die diese Art von Lernen erst möglich macht ist die interaktive Natur von Sprache: Menschen stellen Fragen und beantworten diese, teilen mit, wenn sie etwas nicht verstehen und verhandeln bis sie es dann verstehen (Levinson 2014). Programmiersprachen andererseits sind passiv: Sie führen Anweisungen aus und spucken Fehlermeldungen aus, aber sie finden Code nicht interessant oder langweilig und stellen auch keine Fragen.

Deshalb ist es manchmal schwierig in einer Programmiersprache zu denken, also Anweisungen umfassend und komplett eindeutig zu formulieren. Die gute Nachricht ist, dass viele moderne Programmiersprachen die selben Konzepte und Strukturen benutzen, weil sie alle auf den selben Prinzipien beruhen. Das bedeutet, dass es oft relativ einfach ist eine zweite Programmiersprache zu lernen, wenn man bereits eine andere gut beherrscht. Eine Fremdsprache zu lernen bedeutet da oft wesentlich mehr Aufwand. Eines ist jedoch klar: Es wird immer wichtiger beide Arten von Sprache zu beherrschen.

Weiterführende Literatur

The children who learned to use computers without teachers

Levinson, S. C. (2014). Pragmatics as the origin of recursion. In F. Lowenthal, & L. Lefebvre (Eds.), Language and recursion (pp. 3-13). Berlin: Springer.

By: Julia Udden, Harald Hammarström and Rick Janssen

Aus dem Englischen übersetzt von Tayo Takada & Sebastian Sauppe

- Was haben Programmiersprachen mit natürlichen Sprachen gemeinsam?

-

Manche Programmiersprachen lesen sich in der Tat fast wie einfache englische Sätze. Hier ist beispielsweise ein kleines Programm, das in der Programmiersprache Python geschrieben ist. Es durchsucht eine Liste von Namen und wirft jeden Namen aus, der auch in der Liste "invited_people" ("geladene_Gäste") vorkommt:

Python

for name in my_list: if name in invited_people: print name

Andere Programmiersprachen hingegen sind weit weniger lesbar. Hier ist das selbe Programm noch einmal in der Programmiersprache Scheme:Scheme

(map (lambda (name) (if (cond ((member name invited_people) name)) (display name) name)) my_list)

Wie ähnlich oder unterschiedlich sind sich natürliche Sprachen und Programmiersprachen denn nun? Um diese Frage zu beantworten, müssen wir zunächs über einige zentrale Begriffe sprechen, mit denen Sprachwissenschaftler die Struktur natürlicher Sprachen beschreiben. Sonst laufen wir Gefahr uns an oberflächlichen Ähnlichkeiten aufzuhalten.Strukturelle Ähnlichkeiten mit Semantik und Syntax

Zwei der wichtigsten Begriffe in der Sprachwissenschaft sind Semantik und Syntax. Einfach gesagt ist Semantik der sprachwissenschaftliche Fachbegriff für "Bedeutung". Genauer gesagt beinhaltet Semantik sämtliche Informationen, die mit einem Konzept verbunden sind. Das Konzept "schlafen" (dessen Form entweder buchstabiert <s-c-h-l-a-f-e-n> ist oder ausgesprochen [ˈʃla:fn̩]) bezeichne eine Handlung eines Lebewesens und das ist die Sematik dieses Wortes.

Die Syntax andererseits ist die Lehre davon wie Worte unterschiedlicher Art (z.B. Nomen und Verben) miteinander kombiniert werden können. Der Satz "Meine Ideen schlafen" ist ein wohlgeformer deutscher Satz aus Sicht der Syntax, aber die Semantik ist fragwürdig, weil Ideen nicht lebendig sind und daher nicht schlafen können. Semantik und Syntax folgen also beide Gesetzmäßigkeiten, denen zufolge einige Konzepte zusammenpassen und andere nicht. Der Unterschie ist, das Semantik sich auf die Bedeutung bezieht und Syntax auf die Wortart und Wortform (also unterschiedliche Flexionen des selben Begriffs wie Du suchst, das Suchen, die Durchsuchung) und wie diese Wortformen kombiniert werden können.

Jetzt wissen wir etwas über Semantik und Syntax in natürlichen Sprachen. Wie sieht es mit Programmiersprachen aus? Der Programmierer beginnt mit einer Absicht was sein Code leisten soll. Das könnte man die Semantik oder Bedeutung des Codes nennen. Die Syntax der Programmiersprache verbindet einzelne Code-Schnipsel miteinander. Was in natürlicher Sprache die Worte sind, sind in der Programmiersprache Variablen, Funktionen, Indizes, unterschiedliche Arten von Klammern, usw. Die beiden Code-Beispiele aus Python und Scheme haben also die selbe Bedeutung, aber die Syntax unterscheidet sich (so wie sich die Syntax natürlicher Sprachen wie Deutsch und Japanisch unterscheidet).

Unterschiedliche Ziele

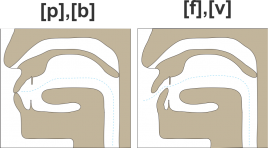

Wir haben einige Parallelen im grundlegenden Aufbau von natürlichen Sprachen und Programmiersprachen festgestellt. Aber wie weit kommt man mit dieser Analogie wirklich? Die Form von natürlichen Sprachen ist nicht willkürlich. Sie wird bestimmt durch die anatomischen Gegebenheiten des Menschen (Zunge, Stimmbänder, etc. auf der einen Seite und Gehirn auf der anderen) und dadurch, dass sie zur Kommunikation taugen muss. Programmiersprachen andererseits sind darauf ausgelegt, die Anforderungen einer sogenannten Turing-Maschine zu erfüllen, also in der Lage zu sein, alle Berechnungen, die ein Mensch mit Block und Bleistift durchführen kann, wieder und wieder durchzuführen.

Programmiersprachen sind notwendigerweise in sich geschlossen. Natürliche Sprachen hingegen befinden sich in stetem Wandel und erlauben Überblendungen (z.B. Demokratur, Denglisch, jein, usw.). Programmiersprachen ermöglichen es, lange Listen von Daten einzulesen, zu speichern und in vielen Einzelschritten rasch zu verarbeiten, um schließlich einen Output oder ein Endergebnis zu liefern. Das Wichtige daran ist, dass dies immer auf die selbe Art und Weise geschieht. Natürliche Sprachen müssen ihren Sprechern dagegen Möglichkeiten bereit stellen, sich zu grüßen, Versprechen zu machen, aber auch manchmal vage zu bleiben oder zu lügen. Neue Begriffe und syntaktische Strukturen tauchen unentwegt auf und verschwinden wieder und auch die Bedeutungen bereits vorhandener Wörter befinden sich in einem anhaltenden Wandel. Ein Satz in einer gesprochenen Sprache kann verschiedene Bedeutungen haben. Beispielsweise kann der Satz "Ich habe den Hund mit dem eleskop gesehen" bedeuten, das ich einen Hund durch mein Teleskop gesehen habe oder dass ich einen Hund gesehen habe, der ein Teleskop besitzt. Menschen nutzen Kontext und Weltwissen, um zwischen diesen möglichen Interpretationen zu wählen. Die Grundlage natürlicher Sprachen ist also eine sich ständig wandelnde Kultur, sei es durch Vermischung bestehender Kultur(en) oder durch Schaffung neuer Kultur. Programmiersprachen sind nicht annährend so flexibel. In Prgrammiersprachen muss eine Zeile Code eine einzige Bedeutung haben, so dass der Output mit Sicherheit reproduzierbar ist.

By: Julia Udden, Harald Hammarström and Rick Janssen

Aus dem Englischen übersetzt von Tayo Takada & Sebastian Sauppe

- Beeinflussen geschlechtsanzeigende Artikel allgemeine Gedankengänge?

-

Sprachen organisieren ihre Substantive (auch Nomen genannt) auf unterschiedliche Art und Weise. Manche haben gar keine Klassifizierung der Substantive (z. B. Englisch: jedes Substantiv kann durch „it“ ersetzt werden), manche haben zwei Klassen (z. B. Französisch: jedes Substantiv ist entweder männlich oder weiblich), manche haben sogar 16 (z. B. Swahili: verschiedene Klassen für belebte Dinge, unbelebte Dinge, Werkzeuge, Früchte, …). Manche Sprachen mit zwei Substantivklassen unterscheiden zwischen männlich und weiblich (z. B. Französisch), manche zwischen ‚gemeinsam‘ (männlich und weiblich) und neutral (z. B. Niederländisch). All diese Sprachen unterscheiden sich offenkundig auf der Ebene ihres sogenannten ‚grammatikalischen Geschlechtssystems‘. Während westeuropäische Sprachen eventuell den Eindruck erzeugen, dass grammatikalische Geschlechter vor allem die Artikel vor Substantiven beeinflussen (e.g. „der“, „die“, oder „das“ im Deutschen), werden oft auch die Substantive selbst, sowie andere Wörter die mit ihnen in Verbindung stehen, beeinflusst. Polnisch, zum Beispiel, besitzt gar keine Artikel (als ob es im Englischen das Wort „the“ nicht gäbe), und hat trotzdem ein komplexes Geschlechtssystem welches Adjektive an Substantive angleicht. Die Gründe für diese Unterschiede zwischen den Sprachen bleiben rätselhaft.

Da nun das Geschlechtssystem einer Sprache alle Sätze durchdringt, kann man sich fragen, ob es auch darüber hinaus einen Einfluss auf die Gedankengänge der Sprachnutzer im Allgemeinen hat. Auf den ersten Blick erscheint das unwahrscheinlich. Ein grammatikalisches Geschlechtssystem ist einfach nur ein Regelwerk, um zu bestimmen, wie Wörter verändert werden müssen, wenn sie kombiniert werden. Es gibt keinen ‚tieferen‘ Sinn hinter diesen Regeln. Und doch haben eine Reihe von Experimenten überraschende Resultate zu Tage gefördert.

In den Achtzigern ist Alexander Guiora und seinen Kollegen aufgefallen, dass zwei- bis dreijährige hebräischsprechende Kinder (deren Sprache zwischen männlichen und weiblichen Substantiven unterscheidet) ungefähr ein halbes Jahr Vorsprung auf ihre englischsprechenden Altersgenossen haben, was die Entwicklung ihrer sozialen Geschlechtsidentität angeht. Es ist, als ob die Unterscheidung zwischen hebräischen Substantiven diesen Kindern ein Hinweis war, dass ähnliche Geschlechtsunterschiede auch in der natürlichen Umgebung vorkommen.

Auch Erwachsene scheinen grammatikalische Geschlechter zu benutzen, selbst wenn es ihnen keinen Vorteil bringt. Roberto Cubelli und seine Kollegen fragten Versuchspersonen zu entscheiden, ob zwei Objekte der gleichen Kategorie (z. B. Werkzeuge, Möbel etc.) angehören oder nicht. Wenn die Geschlechter der Objekte übereinstimmten, wurden die Entscheidungen schneller gefällt, als wenn sie nicht übereinstimmten. Die Aufgabe beinhaltete nicht das Benennen der Objekte. Trotzdem scheinen die Teilnehmer der Studie das willkürliche Geschlechtssystem ihrer Muttersprache benutzt zu haben.

Edward Segel und Lera Boroditsky fanden den Einfluss grammatikalischer Geschlechter sogar außerhalb des Labors: in einem Lexikon klassischer Malerei. Sie untersuchten alle geschlechtlichen Darstellungen von eigentlich asexuellen Begriffen, wie z. B. Liebe, Gerechtigkeit und Zeit. Es fiel ihnen auf, dass diese Dinge durch männliche Wesen personifiziert wurden, wenn das grammatikalische Geschlecht in der Sprache des Malers auch männlich war (z. B. Französisch: ‚le temps‘) und umgekehrt für weibliche Charaktere (z. B. Deutsch: ‚die Zeit‘). Das dargestellte Geschlecht stimmte mit dem grammatikalischen Geschlecht zu 78% überein, wenn die Sprache des Malers ‚geschlechtlich‘ war, wie zum Beispiel Italienisch, Französisch und Deutsch. Obendrein war der Effekt noch stets präsent, wenn man nur die Begriffe berücksichtigte, die verschiedene Geschlechter in den untersuchten Sprachen hatten.

Diese und ähnliche Studien haben deutlich gezeigt, inwiefern das Klassifizierungssystem für Substantive einen Einfluss auf die allgemeine Wahrnehmung von Sprachnutzern hat. Indem es Leute zwingt, in bestimmten Kategorien zu denken, werden auch generelle Denkgewohnheiten beeinflusst. Dies zeigt recht eindrücklich, dass Gedanken durch die Dinge beeinflusst werden, die man sagen muss, nicht jene, die man sagen kann. Der Effekt grammatikalischer Geschlechter auf allgemeine Gedankengänge zeigt, dass Sprache keine isolierte Fähigkeit ist, sondern im Zentrum vieler Gedankengänge steht.

Geschrieben von Richard Kunert und Gwilym Lockwood

Übersetzt von Richard Kunert

Mehr Lektüre:

Segel, E., & Boroditsky, L. (2011). Grammar in art. Frontiers in Psychology, 1,1. doi: 10.3389/fpsyg.2010.00244

- Ist es unvermeidbar, dass das regelmäßige Sprechen einer Fremdsprache unsere eigene Muttersprache beeinflusst?

-

Viele Menschen, die eine Fremdsprache lernen oder häufig mit Menschen in Kontakt sind, die eine Fremdsprache lernen, bemerken, dass die Art und Weise, wie wir die Fremdsprache sprechen stark von unserer Muttersprache beeinflusst wird. Oft ist ein charakteristischer, nicht-muttersprachlicher Akzent erkennbar und es kommt vor, dass die Sprecher Wörter oder falsche grammatische Strukturen in der Fremdsprache verwenden, die sie so aus ihrer Muttersprache übernehmen. Ein weniger bekanntes Phänomen ist jedoch, dass das Sprechen einer Fremdsprache die eigene Muttersprache beeinflusst.

Menschen, die beginnen regelmäßig eine Fremdsprache zu sprechen (zum Beispiel nachdem sie ins Ausland gezogen sind), bemerken, dass es ihnen manchmal schwer fällt, sich an Wörter der Muttersprache zu erinnern. Es kommt häufig vor, dass sich diese Menschen Wörter aus der Fremdsprache "leihen" wenn sie ihre Muttersprache sprechen. Niederländer, die zum Beispiel häufig Englisch sprechen, verwenden beim Sprechen der Muttersprache vermehrt englische Wörter, für die es im Niederländischen keine direkte Übersetzung gibt (so z.B. das Wort native). Sie verwenden manchmal auch wörtliche Übersetzungen von englischen Redewendungen, die im Niederländischen jedoch anders gebildet werden (z.B. take a photo heißt wörtlich übersetzt ein Foto nehmen, bedeutet allerdings ein Foto machen).

Experimentelle Untersuchungen in den letzten Jahrzehnten haben gezeigt, dass diese Einflüsse auf verschiedenen sprachlichen Ebenen erkennbar sind. Das bedeutet, dass sowohl die Wortwahl (das muttersprachliche Lexikon), der Satzbau (die Syntax) als auch die Aussprache der Muttersprache der Fremdsprache beeinflusst werden können. Die Forschungsergebnisse deuten darauf hin, dass alle Sprachen, die wir beherrschen, beim Sprechen automatisch ko-aktiviert werden. Das bedeutet, wenn beispielsweise ein Niederländer Deutsch spricht, werden sowohl sein Deutsch als auch sein Niederländisch sowie alle weiteren Sprachen, die diese Person spricht, zur selben Zeit aktiviert. Diese Ko-Aktivierung ist eine sehr wahrscheinliche Ursache für die oben beschriebenen cross-linguistischen Einflüsse.

Heißt das, dass die eigene Muttersprache zwangsläufig und auf allen sprachlichen Eben durch das Lernen einer neuen Sprache beeinflusst wird? Zu einem bestimmten, vielleicht nicht immer offensichtlichen Grad schon. Es gibt jedoch von Sprecher zu Sprecher große individuelle Unterschiede. Der Einfluss der Fremdsprache auf die Muttersprache verstärkt sich mit der Dominanz der Fremdsprache im täglichen Gebrauch und vor allem dann wenn man häufig mit Muttersprachlern interagiert (z.B. wenn man ins Ausland gezogen ist). Weiterhin nimmt der Einfluss mit der Zeit zu. Es ist wahrscheinlicher, dass Menschen, die ins Ausland auswandern, nach 20 Jahren (verglichen mit nur zwei Jahren im Ausland) solche Effekte zeigen, obwohl natürlich der regelmäßige Gebrauch der Fremdsprache besonders am Anfang ebenfalls einen großen Einfluss hat. Einige Wissenschaftler haben vorgeschlagen, dass individuelle Unterschiede zwischen Menschen stark von kognitiven Fähigkeiten abhängen, also beispielsweise davon wie gut eine Person irrelevante Informationen unterdrücken kann. Jemand, der besser darin ist, irrelevante (z.B. visuelle oder auditive) Informationen zu unterdrücken, sollte also nach dieser Auffassung in der Lage sein, die Einflüsse der Fremdsprache auf die Muttersprache zu minimieren. Es muss betont werden, dass einige dieser Einflüsse sehr subtil sind und in einer normalen Unterhaltung möglicherweise gar nicht erkennbar sind.

Geschrieben von Shiri Lev-Ari und Hans Rutger Bosker

Übersetzt von Florian Hintz und Cornelia Moers

Weiterführende Literatur:

Cook, V. (Ed.). (2003). Effects of the second language on the first. Clevedon: Multilingual Matters.

- Warum können mehrsprachige Menschen nach einem Schlaganfall manchmal nur noch eine ihrer beiden Sprachen sprechen?

-

Bei einem Schlaganfall ist die Blutzufuhr in bestimmten Hirnarealen kurzeitig gestört. Das passiert entweder durch eine Gehirnblutung oder durch die Blockierung eines Blutgefäßes. Wenn der Schlaganfall Hirnareale betrifft, die eine wichtige Rolle für Sprache spielen, können Sprachfunktionen teilweise oder sogar ganz verloren gehen. Dies wird Aphasie genannt. Mit viel Zeit, der richtigen Behandlung und Rehabilitation kann eine Aphasie in manchen Fällen zumindest zu einem gewissen Grad geheilt werden. Menschen, die mehr als eine Sprache sprechen, also Zwei- bzw. Mehrsprachige, können sich auf verschiedene Weisen von einem Schlaganfall erholen. Der wahrscheinlichste Fall ist, dass der Patient die Sprachfertigkeit in beiden Sprachen auf eine ähnliche Weise gleich wiedererlangt (parallele Aphasie). In einigen Fällen wird eine der Sprachen jedoch unverhältnismäßig schnell und besser wiedererlangt als die andere(n) Sprache(n) (selektive Aphasie).

Die Bekanntheit der Fälle von selektiver Aphasie bei mehrsprachigen Patienten sorgte dafür, dass Forscher anfänglich annahmen, verschiedene Sprachen seien in verschiedenen Hirnarealen gespeichert. Dank bildgebender Verfahren in der Neurowissenschaft wissen wir heute jedoch, dass dies nicht der Fall ist. Im Gegenteil, auch wenn eine Person viele unterschiedliche Sprachen spricht, werden stets die gleichen Gehirnregionen aktiviert. Während wir leider noch immer nicht vollständig verstehen, wie unser Gehirn dazu in der Lage ist, mehrere Sprachen zu beherrschen, so kennen wir doch bereits einige Faktoren, die einen Einfluss darauf zu haben scheinen, bis zu welchen Grad ein mehrsprachiger Patient seine Fähigkeit zu sprechen wiedererlangen wird. Wenn eine Sprache zum Beispiel weniger gut beherrscht wurde, wird diese vermutlich nicht so gut wiedererlangt wie die Sprache, die besser beherrscht wurde. Das bedeutet je automatischer eine Fähigkeit ist, desto leichter ist es diese nach einem Schlaganfall wieder zu erlangen. Fähigkeiten, die viel Mühe kosten, wie das sprechen einer Sprache, die man kaum benutzt, sind hingegen viel schwieriger wieder zu erlangen. Soziale Faktoren und emotionale Verbundenheit spielen ebenfalls eine wichtige Rolle, wenn wir verstehen wollen, welche Sprache nach einem Schlaganfall wiedererlangt wird. Hierbei kommt es zum Beispiel darauf an wie häufig eine Sprache verwendet wird oder welche Gefühle wir mit einer Sprache verbinden. Obgleich wir wissen, dass diese Faktoren eine wichtige Rolle spielen, muss erst noch erforscht werden wie die Faktoren genau miteinander zusammenhängen, um erfolgreich den Wiedererlangungsprozess einer Sprache vorhersagen zu können.

Eine der derzeitigen Theorien führt selektive Aphasien darauf zurück, dass bei Schlaganfällen Bereiche geschädigt werden, die für bestimmte Kontrollmechanismen zuständig sind. Mehrsprachige Personen müssen beim Gebrauch einer ihrer Sprachen die jeweils anderen unterdrücken bzw. 'ausschalten'. Wenn diese Umschaltmechanismen bei einem Schlaganfall beschädigt werden, kann es passieren, dass der Patient nicht mehr in der Lage ist, beide Sprachen gleichmäßig wiederzuerlangen, weil die Fähigkeit Sprache zu steuern verloren gegangen ist. In einem solchen Fall sieht es so aus als sei eine der Sprachen komplett verloren, jedoch liegt das Problem in den Kontrollmechanismen. Vor kurzem haben Forscher Indizien dafür gefunden, dass Kontrollmechanismen bei zweisprachigen Menschen mit selektiver Aphasie stärker beeinträchtigt sind als bei Patienten mit paralleler Aphasie. Interessanterweise werden beim Wiedererlangen von Sprache nach einem Schlaganfall neuronale Verbindungen zwischen Sprache und Kontrollmechanismen wiederhergestellt. Auch wenn dieser interessante Befund für die Theorie eines Zusammenhangs zwischen selektiver Aphasie und Kontrollmechanismen spricht, ist dies jedoch nur eines von vielen Erklärungsmodellen. Derzeit arbeitet die Forschung daran, ein besseres Verständnis der verschiedenen Faktoren zu erlangen, die den ungewöhnlichen Heilungsverläufen von mehrsprachiger Aphasie nach Schlaganfällen noch zugrunde liegen könnten.

Diana Dimitrova and Annika Hulten

Übersetzt von Franziska Hartung & Louise Schubotz

Fabbro, F. (2001). The bilingual brain: Bilingual aphasia. Brain and Language, 79(2), 201-210. pdf

Green, D. W., & Abutalebi, J. (2008). Understanding the link between bilingual aphasia and language control. Journal of Neurolinguistics, 21(6), 558-576.

Verreyt, N. (2013). The underlying mechanism of selective and differential recovery in bilingual aphasia. Department of Experimental psychology, Ghent, Belgium. pdf

- Warum haben manche Sprachen ein Schriftsystem, das relativ genau widerspiegelt wie die Sprache gesprochen wird, während andere Sprachen ein weniger deutliches Schriftsystem haben?

-

Keine Sprache hat eine Rechtschreibsystem (Orthographie) welches den Klang von Woertern absolut und vollständig wiedergibt, aber einige sind definitiv besser als andere. Italienisch z.B. hat eine seichte Orthographie. Das bedeutet, dass die Schreibweise der Wörter die Klänge des Italienischen recht gut repräsentieren (obwohl sizilianische, sardinische und neapolitanische Sprecher hier anderer Meinung sein könnten). Englisch hat dagegen eine tiefe Orthographie, was bedeutet, dass Rechtschreibung und Aussprache weniger gut übereinstimmen.

Im Folgenden möchten wir die zwei Hauptgründe erläutern, warum Italienisch relativ konsistent ist, Erstens reguliert die Accademia della Crusca die italienische Sprache seit ihrer Gründung in 1583. Seitdem hat sie einige Jahrhunderte damit verbracht eine umfassende und effektive Konsistenz in der italienischen Rechtschreibung festzulegen. Zweitens hat das normale Italienisch nur fünf Vokale: a, i, u ,, e und o . Das macht es theoretisch viel einfacher zwischen den verschiedenen Vokalen zu unterscheiden. Andere Beispiele für Sprachen mit fünf Vokalen sind Spanisch und Japanisch, beide auch mit seichter Orthographie.

Japanisch ist ein interessanter Fall. Einige Worte werden mit japanischen Schriftzeichen geschrieben, welche den Klang der Worte genau darstellen. Andere Wörter wiederum werden mit angepassten chinesischen Schriftzeichen geschrieben, die zwar die Bedeutung der Worte nicht aber den Ton darstellen.

Französisch hat eine tiefe Orthographie die jedoch nur einseitig ist. Während im Französischen ein Ton auf verschiedene Weisen geschrieben werden kann, gibt es in der Regel nur eine bestimmte Art und Weise einen bestimmten Vokal oder eine Kombination von Vokalen auszusprechen. Zum Beispiel kann der Klang [o] wie au , eau, oder o geschrieben werden (wie z. B. in haut , oiseau, und mot). Das geschriebene Wort eau wird im Französischen jedoch eindeutig als [o] ausgesprochen.Englisch hat inzwischen eine sehr tiefe Orthographie und hat einer möglichen Rechtschreibreform seit Jahrhunderten erfolgreich widerstanden (interessanterweise ist dies in den USA nicht der Fall; das Noah Webster American Dictionary of the English Language hat erfolgreich eine modernisierte Rechtschreibreform etabliert) . Ein offensichtlicher Grund ist das Fehlen einer Akademie für die englische Sprache. Andere Gründe hierfür sind, dass sich Englisch aus einer Mischung vieler europäischer Sprachen entwickelt hat: Ein Klecks Latein und Griechisch hier, eine Prise Französisch und Keltisch da, ein paar Brocken Deutsch, und eine Handvoll der nordischen Sprache - Englisch hat eine lange und komplizierte Geschichte. Einige Rechtschreibunregelmäßigkeiten im Englischen spiegeln die ursprüngliche Etymologie der Wörter wider. Die englischen Wörter send und sell kommen z. B. ursprünglich aus dem Germanischen. Hier wird das gesprochene ,‚se‘‘ auch tatsächlich wie se- geschrieben. Die Aussprache des ce- als "se " in centre, certain und celebrity wurde wiederum vom Französischen beeinflusst. Das unausgesprochene b in doubt und debt geht zurück auf lateinische Wurzeln (z.B. dubitare und debitum).

Alle Sprachen ändern sich mit der Zeit. Die englische Sprache erfuhr im Mittelalter jedoch eine Reihe von tiefgreifenden Änderungen der Klänge seiner Vokale; auch bekannt als die Frühneuenglische Vokalverschiebung (engl: the Great Vowel Shift ). Die frühen und mittleren Phasen dieser Bewegung fielen zeitlich mit der Erfindung der Druckerpresse zusammen, was dazu beitrug die englische Rechtschreibung an diesem Punkt einzufrieren. Daraufhin hat sich die Aussprache noch weiterentwickelt und verändert; die Schreibweise jedoch blieb immer gleich. Dies bedeutet, dass im heutigen English viele Worte noch buchstabiert werden, wie sie vor 500 Jahren einmal ausgesprochen wurden. Shakespeares Stücke wurden ursprünglich ganz anders als heute gesprochen, aber die Schreibweise ist noch fast genau die gleiche. Darüber hinaus ist es im Englischen viel schwieriger die Aussprache der Schreibweise anzupassen, weil die Anzahl der Vokale einfach sehr groß ist. Je nach Dialekt produzieren Englischsprachige bis zu 22 einzelne Vokalklänge, die jedoch nur durch die Buchstaben a, i, u, e , o und y vertreten werden. Darum ist es auch kein Wunder, dass so viele konkurrierende Buchstabenkombinationen erstellt wurden.

Tiefe Orthographie macht es schwieriger eine Sprache lesen zu lernen; für sowohl Muttersprachler als auch für Fremdsprachenlerner. Rechtschreibreformen können dies vereinfachen. Trotzdem wehren sich viele Menschen gegen Rechtschreibreformen, weil die Vorteile den Verlust der Sprachgeschichte nicht aufwiegen können. Die Engländer z.B. lieben Regelhaftigkeit, wenn es um Warteschlangen und Tee - nicht aber wenn es um Rechtschreibung - geht.Gwilym Lockwood & Flora Vanlangendonck

Aus dem Englischen übersetzt von Katrin Bangel & Kai Wanke

Siehe auch:

Original- Aussprache auf Shakespeare: http://www.youtube.com/watch?v=gPlpphT7n9s - Wie, in welcher Reihenfolge und warum entwickeln Menschen die verschiedenen Fähigkeiten, die für den Spracherwerb nötig sind?

-

Kinder fangen in der Regel mit zwei oder drei Monaten an zu brabbeln – am Anfang produzieren sie dabei Vokale, später Konsonanten und mit sieben bis elf Monaten schließlich wort-ähnliche Geräusche. Kinder brabbeln, um zu erkunden wie ihr Sprach-Apparat funktioniert, wie sie verschiedene Töne produzieren können. Mit der Produktion von wort-ähnlichen Geräuschen kommt die Fähigkeit, Wörter von einem gegebenen Sprach-Input zu extrahieren. Dies sind wichtige Schritte aus dem Weg zu den ersten Wörtern eines Kindes. Diese produziert ein Kind in der Regel im Alter von 12 Monaten.

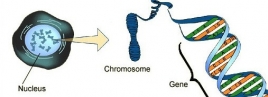

Simplen Ein-Wort-Äußerungen folgen Zwei-Wort-Äußerungen in der zweiten Hälfte des zweiten Lebensjahrs des Kindes, in welchen man bereits Grammatik erkennen kann. Kinder, die mit deutscher oder niederländischer (Subjekt-Objekt-Verb Satzstellung in Nebensätzen, welche eine beständigere Wortreihenfolge als Hauptsätze haben) oder englischer Sprache aufwachsen (Subjekt-Verb-Objekt Satzstellung), produzieren ihre Zwei-Wort-Sätze in Subjekt-Verb Reihenfolge, also zum Beispiel „Ich esse“, während arabisch- oder irisch-lernende Kinder (Sprachen mit einer Verb-Subjekt-Objekt Satzstellung) Sätze wie „Esse ich“ produzieren. Von da an ist ein rapider Anstieg im Vokabular des Kindes zu beobachten, während die produzierten Sätze des Kindes länger und komplexer werden. Man sagt, Grammatik hat sich im Alter von vier bis fünf Jahren vollständig entwickelt. Ab diesem Alter sind Kinder im Grunde linguistische Erwachsene. Das Alter, in dem Kinder diese Fähigkeiten entwickeln, kann von einem Kind zum anderen stark variieren und die Reihenfolge der Entwicklung hängt auch vom linguistischen Umfeld ab, in dem das Kind aufwächst. Aber im Alter von vier oder fünf Jahren haben alle gesunden Kinder Sprache erworben. Der Erwerb von Sprache korreliert mit verschiedenen Prozessen im Gehirn, wie der Formation von konnektiven Nervenbahnen, der Zunahme von metabolischer Aktivität in verschiedenen Gehirnregionen und der Markreifung (die Produktion von Myelinscheiden, die eine Schicht um das Axon eines Neurons bilden und essentiell für die korrekte Funktion des Nervensystems sind).

Von Mariella Paul und Antje Meyer

Aus dem Englischen übersetzt von Mariella Paul

Weitere Informationen:

Bates E, Thal D, Finlay BL, Clancy, B (1999) Early Language Development and its Neural Correlates, in I. Rapin & S. Segalowitz (Eds.), Handbook of Neuropsychology, Vol. 6, Child Neurology (2nd edition). Amsterdam: Elsevier.

- Was sind Homophone und warum gibt es sie?

-

Homophone sind Wörter die gleich klingen aber mindestens zwei unterschiedliche Bedeutungen haben. Dieses Phänomen kommt in allen Sprachen vor. Ein Beispiel aus dem Englischen sind die Worte FLOWER (Blume) und FLOUR (Mehl), während im Deutschen beispielsweise LEERE und LEHRE Homophone sind. Obwohl diese Wortpaare jeweils gleich ausgesprochen werden, unterscheiden sie sich in ihrer Bedeutung und in ihrer Schreibweise (sie werden deshalb auch heterographe Homophone genannt). Es gibt aber auch Homophone die gleich klingen und gleich geschrieben werden, zum Beispiel die Wörter BANK (Sitzmöbel) und BANK (Geldinstitut) im Deutschen oder Englischen. Solche Wörter werden homographe Homphone genannt. Wörter mit gleichem oder ähnlichem Klang, aber unterschiedlichen Bedeutungen, existieren außerdem über Sprachgrenzen hinweg: zum Beispiel bedeutet das Wort WIE im Deutschen 'wie' (Fragewort der Art und Weise), im Niederländischen aber 'wer' (Personenfragewort).

Man könnte meinen, dass Homophone dem Empfänger oder Zuhörer Probleme bereiten. Denn wie soll ein Zuhörer wissen was ein Sprecher meint, wenn dieser "Ich hasse die Maus!" sagt. Tatsächlich zeigen wissenschaftliche Studien, dass Zuhörer mehr Zeit brauchen um zweideutige Wörter zu verarbeiten als eindeutige Wörter. In den meisten Fällen hilft uns allerdings der Kontext die richtige Bedeutung herauszufiltern. Der obengenannte Satz könnte zum Beispiel in den folgenden Zusammenhängen vorkommen: "Ich habe nichts gegen die Tiere meiner Tochter, aber ich hasse die Maus" oder "Ich liebe meinen neuen Computer, aber ich hasse die Maus". Gewöhnlich filtern Zuhörer die intendierte Bedeutung so schnell heraus, dass sie die mögliche Zweideutigkeit gar nicht erst wahrnehmen. Der vorherige sprachliche Kontext sowie unser allgemeines Weltwissen helfen uns also dabei die vom Sprecher beabsichtigte Bedeutung der Wörter zu erkennen.

Warum existieren Homophone dann eigentlich? Es wäre doch viel weniger verwirrend unterschiedliche Lautkombinationen zu benutzen um unterschiedliche Konzepte auszudrücken. Linguisten nehmen an, dass Lautveränderungen im Zuge des ständigen Sprachwandels zur Existenz von Homophonen führen. So wurde zum Beispiel der erste Buchstabe des englischen Wortes KNIGHT (Ritter) im frühen18. Jahrhundert nicht mehr ausgesprochen, und führte so zur Homphonie mit dem Word NIGHT (Nacht). Auch der Kontakt von Sprachen kann Homophone hervor bringen. Das Englische Wort DATE (Treffen) wurde jüngst ins Niederländische übernommen und bildet nun ein Homophon mit dem Wort DEED (hat getan). Durch Lautveränderungen im Laufe der Zeit können Homophone also entstehen, sie können mit dem Sprachwandel allerdings auch verschwinden. Das Niederländische Verb ZOUDT (würde) beispielsweise wird heute kaum noch genutzt. Dadurch verliert das Nomen ZOUT (Salz) seinen homophonen Charakter.

Eine besonders schöne Eigenschaft von Homophonen ist, dass sie häufig in Wortspielen vorkommen und als Stilmittel in literarischen Texten eingesetzt werden. In Shakespeares Romeo und Julia (Akt I, Szene IV, Zeile 13-16) benutzt Romeo beispielsweise ein Homophon während er Mercutios Vorschlag zu tanzen zurückweist:

Mercutio: Nay, gentle Romeo, we must have you dance. Romeo: Not I, believe me: you have dancing shoes With nimble soles: I have a soul of lead So stakes me to the ground I cannot move.

Dieser elegante Gebrauch von Homophonen hat - unter anderem - zu Shakespeares groβem literarischem Erfolg geführt.Von David Peeters und Antje S. Meyer

Aus dem Englischen übersetzt von Cornelia Moers & Thordis Neger

Weitere Informationen:

Bloomfield, L. (1933). Language. New York: Henry Holt and Company.

Cutler, A., & Van Donselaar, W. (2001). Voornaam is not (really) a homophone: Lexical prosody and lexical access in Dutch. Language and speech, 44(2), 171-195. (link)

Rodd, J., Gaskell, G., & Marslen-Wilson, W. (2002). Making sense of semantic ambiguity: Semantic competition in lexical access. Journal of Memory and Language, 46(2), 245-266. (link)

Tabossi, P. (1988). Accessing lexical ambiguity in different types of sentential contexts. Journal of Memory and Language, 27(3), 324-340. (link)

- Wie entsteht Legasthenie?

-

Verdacht auf Legasthenie besteht, wenn Kinder trotz normaler Intelligenz eine Lern-, Lese- oder Rechtschreibschwäche haben, ohne dass die Sinnesorgane beeinträchtigt sind. Als Entwicklungsstörung wurde Legasthenie 1890 zum ersten Mal beschrieben. Man vermutete, dass die Ursache der Störung eine Beeinträchtigung beim der Verarbeitung von visuellen Symbolen ist. Dadurch entstand im Englischen die Bezeichnung 'congenital word blindness' (also angeborene Wortblindheit). Später fand man jedoch heraus, dass in den meisten Fällen nicht visuelle Defizite für die Legasthenie verantwortlich sind, sondern subtile Sprachschwierigkeiten. Beim Lesenlernen muss ein Kind verstehen, wie Wörter aus individuellen Einheiten (Phonemen) zusammengesetzt werden und lernen diese Phoneme mit Symbolen (Buchstaben) zu verknüpfen. Obwohl die allgemeine Sprachfähigkeit bei Menschen mit Legasthenie in den meisten Fällen normal ist, zeigen sie Schwierigkeiten bei Tests, in denen Lautveränderung und Lautverarbeitung getestet werden; sogar dann, wenn der Test kein Lesen oder Schreiben erfordert.

Legasthenie wird als Leseschwäche ohne offensichtliche Ursache definiert. Daher ist es denkbar, dass die Bezeichnung 'Legasthenie' nicht nur ein einzelnes Syndrom, sondern ein Netzwerk von verschiedenen Störungen umfasst, denen unterschiedliche Mechanismen zu Grunde liegen. Allerdings ist es schwierig Legasthenie in Untertypen zu unterscheiden. Verschiedenen Studien konnten bereits bedeutende Zusammenhänge von Leseproblemen und anderen Verhaltensmustern aufzeigen. Viele Menschen mit Legasthenie sind z.B. weniger genau, wenn sie schnell ablaufende Reihen von Objekten oder Farben benennen sollen. Einige Forscher glauben, dass Legasthenie als Ergebnis mehrerer kognitiver Defizite auftritt. Derzeit wird noch diskutiert, wie die verschiedenen Verhaltensmuster in einer kohärenten Theorie zusammengefasst werden können.

Es ist bekannt, dass Legasthenie erblich bedingt ist und genetische Faktoren wesentlich zur Anfälligkeit für die Krankheit beitragen. Die genetische Komponente ist jedoch komplex und sehr heterogen. Dass bedeutet, dass mehrere verschiedene Gene zusammen mit Umgebungsfaktoren zusammenspielen und somit zum Entstehen der Krankheit beitragen. Forscher haben bereits eine Reihe interessanter möglicher Gene gefunden, wie zum Beispiel DYX1C1 , KIAA0319, DCDC2 und ROBO1. Schnelle Fortschritte in der DNA -Sequenzierungs-technologie bieten viel Potential für die Entdeckung weiterer Gene in den kommenden Jahren. Welche neurobiologischen Mechanismen mit Legasthenie assoziiert sind, ist noch weitgehend unbekannt. Eine bekannte Theorie beschreibt Störungen eines Prozesses in der frühen Entwicklung des Gehirns als Ursache. Beim dem Entwicklungsschritt in dem das Auftreten der Störung vermutet wird, bewegen sich die Gehirnzellen des Fötus zu ihrer Endposition in Gehirn. Dieser Vorgang wird neuronale Migration genannt. Indirekte Belege für diese Hypothese kommen aus Studien von menschlichen Gehirnzellen von Verstorbenen und von Untersuchungen von Funktionen einiger möglicher Gene bei Ratten. Es gibt noch viele offene Fragen, die beantwortet werden müssen, bevor wir die kausalen Mechanismen, die diesem schwer fassbaren Syndrom zugrunde liegen, voll und ganz verstehen.

by Simon Fisher

Aus dem Englischen übersetzt von Katrin Bangel & Franziska HartungVorschläge zum weiterführenden Lesen:

Carrion-Castillo, A., Franke, B., & Fisher, S. E. (2013). Molecular genetics of dyslexia: an overview. Dyslexia, 19, 214–240. (link)

Demonet J. F., Taylor M. J., & Chaix, Y. (2004). Developmental dyslexia. Lancet, 63, 1451–1460 (link)

Fisher, S. E. & Francks, C. (2006). Genes, cognition and dyslexia: learning to read the genome. Trends in Cognitive Science, 10, 250-257.(link)

- Verstehen zwei Menschen mit unterschiedlichen Gebärdensprachen die Gebärden der anderen Person?

-

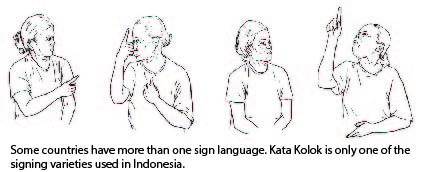

Wenn Menschen außerhalb der Sprachforschung hören, dass wir Gebärdensprache untersuchen oder sie Menschen beobachten die sich mithilfe von Gebärden verständigen, fragen sie oft, ob Zeichensprache universell ist. Die Antwort auf diese Frage ist, dass fast jedes Land mindestens eine nationale Gebärdensprache beheimatet. Außerdem unterscheidet sich Gebärdensprache oft sehr von der dominanten, gesprochenen Sprache in Ursprungsland. Britische und amerikanische Gebärden sehen zum Beispiel sehr verschieden aus. Die chinesische und die niederländische Gebärdensprache unterscheiden sich nicht nur im Vokabular, sondern auch im Finger-Buchstabieren und beide haben weiterhin ihre eigenen grammatischen Regeln. Erstaunlicherweise sind taube Chinesen und taube Niederländer, die auf keine gemeinsame Sprache zurückgreifen können, dennoch in der Lage, sich relativ unkompliziert zu verständigen.

Diese Art von ad-hoc-Kommunikation wird auch als Cross-signing (überkreuzendes Gebärden) bezeichnet. In Zusammenarbeit mit dem ‚Internationalen Institut für Gebärdensprache und Studien zur Taubheit‘ (International Institute for Sign Languages and Deaf Studies - iSLanDS) untersuchen wir, wie genau Cross-signing zwischen Menschen aus unterschiedlichen Herkunftsländern entsteht, wenn diese einander zum ersten Mal begegnen. Dazu analysieren wir Videoaufnahmen von gebärdenden Menschen aus beispielsweise Südkorea, Usbekistan oder Indonesien. Vorläufige Ergebnisse zeigen, dass der kommunikative Erfolg einer solchen Unterhaltung davon abhängt, wie gut die kommunizierenden Personen kreative Gebärden (die nicht Teil der eigenen Sprache sind) benutzen und verstehen können. Diese sprachliche Kreativität zeichnet sich häufig durch sehr bildliche Eigenschaften der Gebärden aus (z.B. die Darstellung eines Kreises in der Luft stellvertretend für ein rundes Objekt, oder der Bezug auf einen Mann durch das Andeuten eines Schnurrbartes). Weiterhin spielen auch generelle Prinzipien menschlicher Interaktion bei der Kreativität eine Rolle, wie zum Beispiel das Wiederholen einer Gebärde als Bitte um mehr Informationen.Cross-signing unterscheidet sich von internationaler Gebärdensprache. Letzte wird zum Beispiel bei internationalen Treffen wie dem Kongress der Weltföderation der Menschen mit Taubheit oder den ‚Deaflympics‘ benutzt. Die internationale Gebärdensprache ist stark geprägt von Gebärden aus der amerikanischen Gebärdensprache und wird bei Präsentationen vor einem internationalen tauben Publikum, das mit den Vokabeln vertraut ist, verwandt. Cross-signing hingegen entsteht wenn zwei Benutzer von Gebärdensprache aufeinandertreffen, die mit der Muttersprache der anderen Person nicht vertraut sind.

Connie de Vos, Kang-Suk Byun & Elizabeth Manrique

Übersetzt aus dem Englischen von Florian Hintz & Katrin BangelWeiterführende Literatur:

Informationen zu Gemeinsamkeiten und Unterschieden zwischen unterschiedlichen Gebärdensprachen, und zwischen gesprochenen und gebärdeten Sprache (verfasst von der Weltföderation der Menschen mit Taubheit) (link)

Mesch, J. (2010). Perspectives on the Concept and Definition of International Sign. World Federation of the Deaf. (link)

Supalla, T., & Webb, R. (1995). The grammar of International Sign: A new look at pidgin languages. In K. Emory and J. Reilly (Eds.), Sign, Gesture and Space. (pp.333-352) Mahwah, NJ: Lawrence Erlbaum.

- Gibt es eine universale Körpersprache?

-

Die meiste Zeit kommunizieren wir auch mit unserem Körper und dies auf sehr unterschiedliche Art und Weise. Eine Form der Kommunikation ist z.B. die Körpersprache. Während einer sozialen Interaktion werden unsere Einstellungen und Emotionen auch durch unseren Körper zum Ausdruck gebracht. Dabei spielt die Dynamik der Interaktion, die zwischen-menschliche Beziehung zum Gesprächspartner und die eigene Persönlichkeit eine Rolle (siehe auch Antwort zur Frage Was ist Körpersprache?). Die Signale, die unser Körper aussendet, sind meistens unbewusst. Darum wäre es schwierig, eine universelle Körpersprache zu finden, die von Menschen aus den unterschiedlichsten Kulturkreisen verstanden, erlernt und benutzt werden kann. Innerhalb einer Kultur gibt es jedoch sehr viele Gemeinsamkeiten wie Menschen ihre Einstellungen und Emotionen durch den Körper ausdrücken.

Eine andere Form von Kommunikation mittels unseres Körpers ist der Gebrauch von sprachbegleitenden Gesten. Diese Gesten, die beim Sprechen produziert werden, sind Bewegungen der Hände, Arme und ab und zu auch anderer Körperteile. Im Vergleich zu Signalen, die durch Körpersprache ausgedrückt werden, stellen sprachbegleitende Gesten Bedeutungen dar, die den Bedeutungen des Gesagten sehr ähneln. Wir schlagen z. B. mit der Faust in die offene Handfläche der anderen Hand, wenn wir von einem Aufprall sprechen. Dennoch ist es selten möglich sprachbegleitende Gesten komplett ohne die dazugehörige Sprache zu interpretieren, weil Sprache und Gestik stets sehr eng miteinander verbunden sind. Wenn die Gesprächspartner unterschiedliche Sprachen sprechen, dann helfen also auch sprachbegleitende Gesten der Kommunikation recht wenig. Außerdem entstehen und verändern sich sprachbegleitende Gesten innerhalb einer Kultur. Dementsprechend unterscheiden sich Gesten bis zu einem gewissen Grad zwischen verschiedenen Kulturen. Darüber hinaus gibt es selbst innerhalb einer Kultur keine Standardform für diese Gesten. Sie werden von jedem ganz individuell beim Sprechen kreiert. Obwohl es Ähnlichkeiten im Gebrauch von Gesten gibt um bestimmte Bedeutungen darzustellen, gibt es von Mensch zu Mensch auch wesentliche Unterschiede. Zur Kommunikation zwischen Menschen, die unterschiedliche Sprachen sprechen, sind sprachbegleitende Gesten dementsprechend nicht als universell einsetzbares Mittels geeignet.

Einen Ausweg, den Menschen oft wählen, wenn sie in einer anderen Sprache zu kommunizieren versuchen, sind pantomimische Gesten oder auch einfach Pantomime. Diese Gesten sind sehr ikonisch, sie stellen also bestimmte Strukturen oder Objekte aus unserer Umwelt dar (wie ein paar wenige ikonische sprachbegleitende Gesten). Selbst wenn sie in erster Linie zusammen mit Sprache produziert wurden, können diese Gesten also auch ohne Sprache verstanden werden. Somit sind diese bei der Kommunikation in einer Fremdsprache viel aufschlussreicher als sprachbegleitende Gesten. Solange wir mit unserem Gegenüber Wissen über unsere Welt teilen, (z.B. über bestimmte Handlungen, Objekte und deren räumliche Bezüge), sind diese Gesten kommunikativ - sogar wenn wir nicht dieselbe Sprache sprechen.

Pantomimischen Gesten, die Informationen auch ohne Sprache übermitteln können, müssen allerdings von Zeichensprachen unterschieden werden. Im Vergleich zu Pantomimen, sind Zeichensprachen von tauben Gemeinschaften vollwertige Sprachen. Sie bestehen aus Formen und Bewegungen, die konventionelle Bedeutungen besitzen und Einheiten gesprochener Sprache entsprechen. Auch hier gibt es nicht DIE universelle Zeichensprache: Unterschiedliche Gemeinschaften haben unterschiedliche Zeichensprachen (deutsche, niederländische, englische, französische oder türkische Zeichensprachen sind nur eine kleine Auswahl).

Judith Holler & David Peeters

Aus dem Englischen übersetzt von Katrin Bangel & Manu SchützeWeiterlesen?

Kendon, A. (2004). Gesture: Visible action as utterance. Cambridge University Press. (link)

Press.McNeill, D. (1992). Hand and mind: What gestures reveal about thought. Chicago University Press.

- Gibt es ein Sprachgen das andere Spezies nicht besitzen?

-

Sprache ist einzigartig in unserer natürlichen Welt und sie ist ein wesentlicher Bestandteil dessen, was den Mensch zum Menschen macht. Obwohl auch andere Spezies über eigene komplexe Kommunikationssysteme verfügen, können selbst unsere nächsten lebenden Verwandten unter den Primaten nicht sprechen, zum Teil, weil sie ihre Lautäußerungen nicht ausreichend kontrollieren können. Einige Schimpansen und Bonobos konnten zwar nach Jahren intensiven Trainings eine rudimentäre Zeichensprache erlernen, selbst diese Ausnahmefälle sind jedoch nichts im Vergleich zu einem sich normal entwickelnden menschlichen Kleinkind, das Sprache spontan und innovativ gebrauchen kann, um Gedanken und Ideen über Gegenwart, Vergangenheit und Zukunft auszudrücken.

Mit Sicherheit spielen Gene eine wichtige Rolle bei der Ergründung dieses Rätsels. Es gibt jedoch kein „Sprach-Gen” oder „Gen für Sprache”, also ein spezielles Gen, das uns mit dieser einzigartigen Fähigkeit ausstattet. Gene bestimmen unsere kognitive Leistung oder unser Verhalten nicht direkt. Vielmehr enthalten sie Blaupläne für Proteine, die ihrerseits Funktionen innerhalb der Körperzellen übernehmen. Einige dieser Proteine haben signifikante Auswirkungen auf die Eigenschaften von Hirnzellen, beispielweise indem sie beeinflussen wie sich diese Zellen teilen, wie sie wachsen und Verbindungen mit anderen Hirnzellen herstellen. Diese Prozesse sind ihrerseits dafür verantwortlich wie unser Gehirn funktioniert, und dazu gehört auch das Sprechen und Verstehen von Sprache. Es ist also gut möglich, dass evolutionsbedingte Veränderungen in bestimmten Genen einen Einfluss darauf hatten, wie die menschlichen Hirnregionen vernetzt sind und somit eine Rolle gespielt haben bei der Entstehung von Sprache. Wahrscheinlich tragen Veränderung in mehreren Genen, nicht nur in einem “magischen Sprachgen” dazu bei. Es gibt keinen Grund anzunehmen, dass entscheidende Gene plötzlich, quasi aus dem Nichts in unserer Spezies aufgetreten sind.

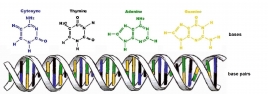

Aus biologischer Sicht gibt es starke Hinweise darauf, dass die menschliche Sprachfähigkeit auf Modifikationen von Gen-Netzwerken basiert die tiefer in der Entwicklungsgeschichte verankert sind. Ein überzeugendes Argument hierfür liefern Studien zu FOXP2 (ein Gen, das in den Medien fälschlicher Weise häufig als das sagenhafte “Sprachgen” dargestellt wird). Es stimmt zwar das FOXP2 relevant ist für Sprache – die Rolle dieses Gens für die menschliche Sprache wurde ursprünglich entdeckt weil eine Unterbrechung des Gens durch seltene Mutationen eine schwere Sprech- und Sprachstörung verursachen. Aber FOXP2 findet sich nicht allein beim Menschen. Ganz im Gegenteil, Varianten dieses Gens finden sich in erstaunlich ähnlicher Form bei vielen Wirbeltieren (unter anderem bei Primaten, Nagetieren, Vögeln, Reptilien und Fischen) und es scheint bei diesen unterschiedlichen Tieren in vergleichbaren Gehirnregionen aktiv zu sein. Singvögel beispielsweise haben ihre eigene Version von FOXP2 die ihnen dabei hilft Singen zu lernen. Eingehende Untersuchungen der verschiedenen Versionen dieses Gens in unterschiedlichen Spezies zeigen, dass es eine Rolle bei der Vernetzung von Gehirnzellen spielt. Das Gen besteht seit vielen Millionen Jahren Evolutionsgeschichte ohne sich viel verändert zu haben, interessanterweise haben aber gerade nach der Abzweigung zum Menschen, d.h., nachdem wir uns von den Schimpansen und Bonobos fort entwickelt haben, mindestens zwei kleine aber interessante Veränderungen in FOXP2 stattgefunden. Wissenschaftler untersuchen nun diese Veränderungen um Herauszufinden, wie sie die Entwicklung von Verbindungen im menschlichen Gehirn beeinflusst haben, ein Puzzleteil bei der Erforschung des Ursprungs unserer Sprache.

by Simon Fisher, Katerina Kucera & Katherine Cronin

Aus dem Englischen übersetzt von Paul Hömke & Louise SchubotzZum weiterführenden Lesen:

Revisiting Fox and the Origins of Language (link)

Fisher S.E. & Marcus G.F. (2006) The eloquent ape: genes, brains and the evolution of language. Nature Reviews Genetics, 7, 9-20. (link)

Fisher, S.E. & Ridley, M. (2013). Culture, genes, and the human revolution. Science, 340, 929-930.(link)

- Gibt es eine schnelle Methode, um meinen englischen Wortschatz zu erweitern?

-

Es ist nicht einfach, eine neue Sprache zu lernen, insbesondere weil man sich so viel Neues eingeprägen muss. Eine beste Methode, die auf jeden zutrifft, existiert wahrscheinlich nicht, aber mithilfe einiger Strategien kann Auswendiglernen effizienter gestaltet werden.

Um einen Wortschatz in einer neuen Sprache aufzubauen, wird häufig die konventionellste Art des Lernens gewählt: Ein Wort dieser neuen Sprache wird in die Muttersprache übersetzt und sich somit gemerkt. Das funktioniert sehr gut, wenn beide Sprachen einander ähneln, wie z.B. Niederländisch und Deutsch. Um allerdings Sprachen zu lernen, die sich vom Deutschen sehr unterscheiden (wie z.B. Chinesisch) ist diese Methode zu indirekt. Eine effizientere Art hierfür ist es, diesen Zwischenschritt wegzulassen: Das neue Wort wird nicht erst in die eigene Sprache übersetzt, sondern direkt mit den Objekten oder Aktionen, das es ausdrückt, verknüpft. Menschen, die fließend eine zweite Sprache sprechen, kommen häufig sogar in die Situation, in der sie Worte benutzen, die es in ihrer Muttersprache noch nicht einmal gibt. Das verdeutlicht, dass es manchmal überhaupt nicht möglich ist, Worte auf konventionelle Art und Weise zu lernen, sondern diese vielmehr aus dem Kontext der neuen Sprache erworben wurden.

Um frühzeitig auf den Zwischenschritt des Übersetzens verzichten zu können, ist es hilfreich, sich bildlich vorzustellen, in welchem Kontext ein Wort benutzt wird. Auf diese Weise koppeln wir das neue Wort an ein Bild und imitieren damit die Art, wie Kinder eine Sprache lernen. Ein weiterer Weg, um seinen Wortschatz schneller aufzubauen, ist es, Gruppen von Worten zu erstellen, die miteinander verwandt sind und diese dann zusammen zu üben. Zum Beispiel kann man auf dem Weg zur Arbeit, alles benennen, das mit Verkehr und Transport zu tun hat oder beim Abendessen alles, das auf dem Tisch steht. Der Trick besteht darin, der neuen Sprache direkt eine Bedeutung zu verleihen anstatt sie durch etwas Vertrautes wie der Muttersprache zu verstehen. Ist man beim Lernen fortgeschritten, kann man dann auf der Suche nach Wortbedeutungen ein Wörterbuch benutzen, das die Wörter nicht in die Muttersprache übersetzt, sondern in der neuen Sprache beschreibt (z.B. das Oxford Advanced Learner's Dictionary für das Englische).

Es gibt eine Methode, die im Englischen "Spaced Learning" genannt wird . Dabei wird neues Wissen (beim Sprachenlernen also neue Wörter) in einem ersten Block eingeführt, in einem zweiten Block wiederholt und schließlich in einem dritten Block überprüft. Zwischen den Blöcken, wird jeweils 10 Minuten Pause gemacht, wobei es wichtig ist, dass sich der Lernende komplett ablenkt und nichts tut, das mit dem gerade Erlerntem zu tun hat (z.B. kurze Fitnessübungen). Studien konnten zeigen, dass diese Kombination von Wiederholung und zeitlich festgelegten Pausen, zu langanhaltenden Verbindungen zwischen Neuronen im Gehirn führen kann und das Erlernte somit im Langzeitgedächtnis gespeichert wird. Diese Vorgänge geschehen innerhalb weniger Minuten und wurden bisher nicht nur beim Menschen beobachtet, sondern auch bei anderen Arten.

Natürlich ist es unvermeidlich, beim Lernen auch wieder etwas zu vergessen oder Fehler zu machen. Im Endeffekt gilt: Je häufiger wir die neuen Wörter verwenden, desto besser erinnern wir uns an sie.

Sylvia Chen & Katerina Kucera

Aus dem Englischen übersetzt von Katrin Bangel & Manu SchützeWeiterlesen?

Kelly P. & Whatson T. (2013). Making long-term memories in minutes: a spaced learning pattern from memory research in education. Frontiers of Human Neuroscience, 7, 589. (link)

- Werden sich Sprachen mit der Zeit immer ähnlicher oder unterscheiden sie sich immer mehr voneinander?

-

Es gibt folgende Annahme bezüglich des Wandels einer Sprache: Spaltet sich eine Sprachgemeinschaft in zwei Gruppen auf, die fortan keinen Kontakt mehr miteinander haben, so entwickelt sich die ehemals gleiche Sprache mit der Zeit immer weiter auseinander. Wenn beide Gruppen wieder in Kontakt miteinander kommen, können sich beide Sprachen jedoch wieder annähern, indem sie bestimmte Bestandteile voneinander übernehmen. In vielen Teilen der Erde ist genau das passiert -bestimmte Bestandteile einer Sprache wurden in andere Sprachen übernommen. Ein aktuelles Beispiel ist das Wort 'Internet', das seinen Weg in viele Sprachen gefunden hat. Als globale Kommunikation noch nicht so ohne weiteres möglich war, beschränkten sich diese Entlehnungen nur auf Sprachen in denselben oder angrenzenden Gebieten. Dadurch konnte es sein, dass sich Sprachen immer ähnlicher wurden. Sprachwissenschaftler nennen das im Englischen areal effects (dt. etwa "gebietliche oder räumliche Effekte"). Bei der Annäherung an eine andere Sprache spielen soziolinguistische Faktoren eine Rolle, wie z.B. Migration oder dass eine Gruppe stärker oder angesehener als die andere ist.

Ein weiterer Grund, um Worte oder Regeln aus einer anderen Sprache zu übernehmen, ist es, wenn diese einfacher zu lernen sind oder dem menschlichen Gehirn “besser passen”. Das ist in etwa so wie in der Biologie, wenn unterschiedliche Arten ähnliche Merkmale entwickeln, wie z.B. Vögel, Fledermäuse und einige Dinosaurier Flügel entwickelt haben.

Es ist inzwischen auch möglich, dass Sprachen aus gegenüberliegenden Gebieten der Erde sich so ändern, dass sie immer ähnlicher zueinander werden. Wissenschaftler haben Merkmale in Wörtern mehrerer Sprachen entdeckt, die anscheinend einen direkten Zusammenhang zwischen dem Klang und der Bedeutung des Wortes zeigen. In vielen Sprachen beinhaltet bspw. das Wort für 'Nase' Buchstaben, die auch durch die Nase gebildet werden, wie "n". Viele Sprachen benutzen dementsprechend auch ein ähnliches Wort um anzuzweifeln, was jemand gesagt hat: "häh?" oder "was?". Der Grund dafür ist wahrscheinlich, dass es kurz ist, sich wie eine Frage anhört und man sehr schnell die Aufmerksamkeit von anderen bekommt.

Es ist schwierig, zu unterscheiden, ob die Worte zweier Sprachen ähnlich sind, weil sie universelle Merkmale enthalten (wie oben beschrieben) oder weil sie voneinander übernommen wurden. Evolutionäre Sprach-wissenschaft versucht, Wege zu finden, um diese Unterschiede deutlich zu machen.

Durch evolutionäre Sprachwissenschaft wird auch eine Frage beantwortet, die der gesamten sprachwissenschaftlichen Forschung zugrunde liegt: Gibt es Grenzen in der Vielfalt von Sprachen? In frühen Theorien wurde davon ausgegangen, dass wir durch unsere Biologie eingeschränkt sind und nur bestimmte Strukturen verarbeiten können. Allerdings haben Feldforscher in letzter Zeit immer mehr Sprachen dokumentiert, die eine riesige Anzahl an verschiedenen Tönen, Worten und Regeln besitzen. Vielleicht ist es also der Fall, dass jedes Mal, wenn sich zwei Sprachen annähern, sie sich auf eine andere Art und Weise weiter unterscheiden.

By Seán Roberts & Gwilym Lockwood

Aus dem Englischen übersetzt von Manu Schütze & Katrin BangelSome links

Can you tell the difference between languages? (link)

Why is it studying linguistic diversity difficult? (link)

Is ‘huh?’ a universal word? (link)Further Reading

Nettle, D. (1999). Linguistic Diversity. Oxford: Oxford University Press.

Dingemanse, M., Torreira, F., & Enfield, N. J. (in press). Is “Huh?” a universal word? Conversational infrastructure and the convergent evolution of linguistic items. PLoS One. (link)

Dunn, M., Greenhill, S. J., Levinson, S. C., & Gray, R. D. (2011). Evolved structure of language shows lineage-specific trends in word-order universals. Nature, 473, 79-82. (link)

- Wenn Wissenschaftler von maternal language (dt. in etwa "mütterliche Sprache") sprechen, meinen sie dann Muttersprache?

-

Image: Eoin Dubsky Mit maternal language meinen Wissenschaftler die Art und Weise, wie oftmals mit Kindern gesprochen wird. Wie Eltern oder Betreuer mit Kindern reden, wird in der Sprachwissenschaft ungefähr seit den siebziger Jahren untersucht. Wissenschaftler, die sich mit dem Spracherwerb von Kindern beschäftigen, wollten verstehen, welchen Einfluss die Art und Weise des Sprechens auf das Lernen einer Sprache auf Kinder haben kann. Weil sich hauptsächlich Mütter um Kinder kümmern, konzentrierten sich die Wissenschaftler anfangs auf die "mütterliche Sprache" (dt. auch oft Mutterisch genannt, engl. motherese). Ganz allgemein galt, dass bei dieser Art des Sprechens oft höhere Tonlagen, ein breiterer Tonumfang und ein vereinfachter Wortschatz verwendet werden. Inzwischen wissen Wissenschaftler aber, dass das nicht immer das Fall ist. Einige Mütter ändern beispielsweise ihren Tonumfang. Andere Mütter wiederum benutzen bei der Interaktion mit Kinderen fast denselben Tonfall, als wenn sie mit Erwachsenen reden würden. Außerdem ändert sich die Art des Sprechens - entsprechend mit der Weiterentwicklung der sprachlichen Fähigkeiten des Kindes - von Monat zu Monat. In einigen Kulturen benutzen Mütter manchmal auch kaum oder gar keine Babysprache wenn sie mit Kindern reden. Aufgrund dieser großen Variation, ist es schwierig von einer universell gültigen Muttersprache zu sprechen. Darüberhinaus dürfen wir nicht vergessen, dass auch Väter, Großeltern, Babysitter, ältere Geschwister, Cousins sowie Menschen, die nicht zur Familie gehören, ihre Sprache verändern, wenn sie mit Kindern sprechen. Aus diesem Grunde sprechen Wissenschaftler heutzutage lieber von "kindgerichteter Sprache" (engl. child-directed language).

Wissenschaftliche Studien zeigen, dass wir bei der Kommunikation nicht nur unsere Sprache sondern auch unsere Gesten und Handlungen an das Kind anpassen. Wir führen diese langsamer, größer und räumlich näher am Kind aus. Kindgerichtete Sprache scheint also nur ein Teil einer speziellen kindgerechten Kommunikationsform zu sein.

Emanuela Campisi, Marisa Casillas & Elma Hilbrink

Aus dem Englischen übersetzt von Manu Schütze & Katrin BangelWeiterlesen?

Fernald, A., Taeschner, T., Dunn, J., Papousek, M., de Boysson-Bardies, B., & Fukui, I. (1989). A cross-language study of prosodic modifications in mothers' and fathers' speech to preverbal infants. Journal of Child Language, 16, 477–501.

Rowe, M. L. (2008). Child-directed speech: relation to socioeconomic status, knowledge of child development and child vocabulary skill. Journal of Child Language, 35, 185–205.

- Was ist der Unterschied zwischen Oberflächen- und Tiefenstruktur in der Sprache?

-

Image: Duncan Rawlinson Die Begriffe Oberflächenstruktur und Tiefenstruktur beziehen sich auf verschiedene Ebenen die Informationen während der Sprachproduktion durchlaufen. Stellen Sie sich zum Beispiel vor, Sie sehen einen Hund der einen Postboten jagt. Wenn Sie diese Information enkodieren, erstellen Sie eine Repräsentation die drei verschiedene Elemente beinhaltet: einen Hund, einen Postboten, und die Handlung jagen. Diese Informationen existieren im Geist des Sprechers als Tiefenstruktur. Wenn Sie diese Informationen sprachlich ausdrücken möchten, können Sie zum Beispiel einen Satz produzieren wie "Der Hund jagt den Postboten". Das ist die Oberflächenstruktur: Sie besteht aus den Wörtern und Klängen die durch einen Sprecher (oder Schreiber) produziert und durch einen Zuhörer (oder Leser) wahrgenommen werden. Um das selbe Ereignis zu beschreiben, könnten Sie stattdessen auch einen Satz produzieren wie "Der Postbote wird durch den Hund gejagt". In diesem Satz ist die Reihenfolge in der die zwei Charaktere genannt werden (die Oberflächenstruktur) anders als im ersten Satz, aber beide Sätze wurden von der selben Tiefenstruktur abgeleitet. Sprachwissenschaftler vermuten, dass man in der Satzbildung sogenannte Bewegungsoperationen durchführt die enkodierte Informationen aus der Tiefenstruktur in die Oberflächenstruktur umwandeln. Diese Bewegungsoperationen werden auch als sprachliche Regeln bezeichnet. Sprachliche Regeln sind Teil der Grammatik einer Sprache und sie müssen erlernt werden um grammatikalisch korrekte Sätze zu produzieren.

Es gibt Regeln für verschiedene Satztypen. Andere Beispiele für Regeln, oder Bewegungsoperationen zwischen Tiefen- und Oberflächenstrukturen, sind Deklarativsätze (Du hast einen Hund) und ihre korrespondierenden Interrogativsätze (Hast du einen Hund?). In diesem Fall beinhaltet die Bewegungsoperation das Vertauschen der ersten zwei Wörter des Satzes.

By Gwilym Lockwood & Agnieszka Konopka

Aus dem Englischen übersetzt von Paul Hömke & Louise SchubotzVorschläge zum weiterführenden Lesen:

Chomsky, N. (1957). Syntactic Structures. Mouton.

Chomsky, N. (1965). Aspects of the Theory of Syntax. MIT Press. - Technische Hilfsmittel werden immer besser darin die menschliche Hirnaktivität zu imitieren. Werden wir zu dem Punkt kommen, dass Implantate (z.B. von Gehirnen) die stimmlose Kommunikation ermöglichen?

-

Image: Ars Electronica Wir verstehen unser Gehirn derzeitig als Informationsprozessor, vergleichbar mit einem Computer, der es uns ermöglicht mit einem äußerst komplexen Umfeld zu interagieren. Theoretisch sollte es demnach also auch möglich sein, alle Informationen die das Gehirn enthält, zu extrahieren. Das wäre zu schaffen mit einem so genannten 'Brain-Computer Interface' (dt. Gehirn-Computer-Schnittstelle) - also einer Verbindung zwischen Gehirn und Computer. Durch die Messung neuronaler Aktivität und Anwendung anspruchsvoller Computer-algorithmen und maschinellem Lernen (bei dem der Computer im Grunde selber Wissen durch Erfahrung generiert) sind Wissenschaftler nun in der Lage Informationen zu extrahieren und zu reproduzieren. Zum Beispiel können Wissenschaftler Bilddaten verarbeiteten, die durch die Sehrinde produziert wurden. Durch solche Verfahren entsteht eine digitale Momentaufnahme von dem, was jemand mit seinen eigenen Augen wahrgenomen hat.

Im Hinblick auf Sprache haben neuere Studien vielversprechende Ergebnisse gezeigt. Mithilfe von bildgebenden Verfahren (durch die Gehirnaktivität widergeben werden), konnten Wissenschaftler einwandfrei feststellen, ob ihre Versuchsperson gerade Worte von Tieren oder Werkzeugen lasen, hörten, Bilder davon sahen oder ob sie die Töne, die die Tiere oder Werkzeuge verursachten, hörten. Mehr invasive Gehirnaufnahmen haben auch gezeigt, dass wir Informationen über die Sprachlaute extrahieren können die Menschen hören und produzieren. Diese Forschung legt nahe, dass möglicherweise in nicht allzu ferner Zukunft, "neuronale Prothesen" für das Sprechen entwickelt werden. Dadurch könnten Menschen Sprache mithilfe eines Computers produzieren, indem sie einfach nur daran denken, was sie sagen möchten.

Wenn es um stimmlose Kommunikation geht, ist die Anwendung von Brain-Computer-Interfaces (BCIs) aus bestimmten Gründen jedoch noch eine große Herausforderung. Erstens besteht die menschliche Kommuni-kation aus wesentlich mehr als nur Sprechen und Hören. Es gibt eine ganze Reihe von anderen Signalen, die wir verwenden, um zu kommunizieren (z. B. Gesten , Mimik und andere Formen der nonverbalen Kommunikation). Zweitens haben sich BCIs bisher auf das Extrahieren von Informationen aus dem Gehirn beschränkt. Einfügen einer Information in das Gehirn benötigt eine direktere Manipulation der Hirnaktivität, als wir bisher kennen. Cochleaimplantate sind ein Beispiel, bei dem es Wissenschaftlern gelungen ist, eingehende auditive Informationen direkt an Nervenzellen im Ohr weiterzuleiten, sodass taube Menschen wieder hören können. Diese geringe Stimulation kommt allerdings immer noch nicht an die volle Stimulation heran, das das Gehirn für die tägliche Kommunikation benötigt. Es ist also theoretisch möglich, Sprachdaten sowohl ins Gehirn einzulesen, als auch vom Gehirn auszugeben um stimmlose Kommunikation zu ermöglichen. Diese Vorgänge sind jedoch extreme Herausforderungen und benötigen noch weitere, enorme Fortschritte in den Bereichen der Sprachwissenschaft, Neurowissenschaft, Informatik und Statistik.

Dan Acheson & Rick Janssen

Aus dem Englischen übersetzt von Katrin Bangel & Manu SchützeWeiterlesen?

[1] Schoenmakers, S., Barth, M., Heskes, T., & van Gerven, M. A. J. (2013). Linear Reconstruction of Perceived Images from Human Brain Activity. NeuroImage, 83, 951-961.(link)

[2] Simanova, I., Hagoort, P., Oostenveld, R., van Gerven, M.A.J. (2012). Modality-Independent Decoding of Semantic Information from the Human Brain. Cerebral Cortex, doi:10.1093/cercor/bhs324.(link)

[3] Chang, E. F., Niziolek, C. A., Knight, R. T., Nagarajan, S. S., & Houde, J. F. (2013). Human cortical sensorimotor network underlying feedback control of vocal pitch.Proceedings of the National Academy of Sciences, 110, 2653-2658.(link)

[4] Chang, E. F., Rieger, J. W., Johnson, K., Berger, M. S., Barbaro, N. M., & Knight, R. T. (2010). Categorical speech representation in human superior temporal gyrus. Nature neuroscience, 13, 1428-1432.(link)

[5] Bouchard, K. E., Mesgarani, N., Johnson, K., & Chang, E. F. (2013). Functional organization of human sensorimotor cortex for speech articulation. Nature, 495, 327-332. (link)

- Warum schreien wir ‘au’ bei plötzlichem Schmerz?

-

Hinter dieser Frage verstecken sich eigentlich zwei Fragen. Um die Frage klar beantworten zu können, teilen wir sie am besten folgendermaßen auf:

(1) Warum schreien wir auf wenn wir plötzlichen Schmerz erfahren?

(2) Warum schreien wir ‘au!’ und nicht etwas Anderes?

Im Bezug auf die erste Frage ist zu bemerken, dass Schreie im Zusammenhang mit Schmerzen im ganzen Tierreich auftreten. Warum? Darwin, der 1872 ein Buch über Emotionen bei Mensch und Tieren schrieb, dachte, dass es mit der starken Muskelkontraktion zusammenhängt, die bei fast allen Tieren mit Schmerz einhergeht. Er sah dies als eine ritualisierte Version davon, sich eines schmerzverursachenden Stimulus so schnell wie möglich zu entziehen. Aber das führt uns zu der Frage: warum öffnet sich dabei der Mund? Forschung hat seitdem festgestellt, dass das Schreien bei Schmerzen auch kommunikative Funktionen hat: zum Beispiel um Artgenossen bei Gefahr zu warnen, um Hilfe zu rufen, oder um Fürsorge von anderen zu erfahren. Die letztgenannte Funktion beginnt schon in den ersten Sekunden unseres Lebens wenn wir schreien und uns unsere Mutter fürsorglich in die Arme nimmt. Babies, neben den Jungen vieler Tiere, haben ein ganzes Repertoire an verschiedenen Schreilauten. In diesem Repertoire ist der Schmerzensschrei – das Aufschreien bei einer akuten Schmerzerfahrung – immer deutlich erkennbar: er beginnt plötzlich und ist von starker Intensität und kurzer Dauer. Hier erkennen wir schon die Konturen von unserem ‘au!’.

Und damit kommen wir zum zweiten Teil unserer Frage. Warum ‘au!’ und nicht etwas Anderes? Zuerst sollten wir die Frage kritisch betrachten. Ist es wirklich niemals etwas Anderes? Schreien Sie ‘au!’ wenn Sie sich auf den Daumen hauen, oder ist es ‘aaaaah!?’ In Wirklichkeit besteht da viel Variation. Diese Variation ist jedoch begrenzt. Niemand schreit bibibibibi oder vuuuuu bei plötzlichem Schmerz. Schmerzensschreie sind Variationen ein und des selben Musters. Das Muster beginnt mit einem “aa” auf Grund der Form unseres Sprachapparats bei weit geöffnetem Mund und klingt nach “aau” wenn sich der Mund wieder schliesst. Das Wörtchen “au” fasst das Muster sehr gut zusammen. Und damit sind wir bei einer wichtigen Funktion von Sprache. Sprache hilft uns, Erfahrungen die nicht haargenau gleich sind doch als ähnlich zu beurteilen. Das ist nützlich, da, wenn wir darüber reden wollen, wie jemand ‘au’ ruft, wir diesen Schrei nicht exakt imitieren müssen. In diesem Sinne ist “au” ein Wort und nicht nur ein Schrei. Ist “au” dann in allen Sprachen gleich? Fast, aber nicht ganz, weil jede Sprache ihr eigenes Inventar an Klängen zum Ausdrücken von Schmerz benutzt. In Deutsch ist es “au!”, ein Engländer sagt “ouch!”, und jemand aus Israel “oi!” – wenigstens schrieb das Byington in 1942 in einer der ersten vergleichenden Studien über Schmerzensschreie. Jeder von uns kommt mit einem Repertoire an Schmerzensschreien zur Welt und lernt darüberhinaus eine Sprache. Die Sprache sorgt dafür, dass wir mehr als nur weinen und schreien können – wir können Dinge auch besprechen. Glücklicherweise, denn sonst hätte diese Antwort nicht geschrieben werden können.

Verfasst von Mark Dingemanse und publiziert im “Kennislink Vragenboek”

Ins Deutsche übersetzt von Judith Holler, Katrin Bangel & Manu Schütze - Warum brauchen wir feste Rechtschreibregeln?

-

Stellen Sie sich vor, Sie werden gebeten einen Brief an einen Freund zu schreiben und sollen dabei ausschließlich Zahlen und Satzzeichen verwenden. Eventuell finden Sie einen Weg die Zeichen so zu benutzen, dass sie die Laute ihrer Sprache darstellen. Aber wie sollte Ihr Freund dieses neue Alphabet entschlüsseln um den Brief zu lesen? Sie beide hätten zuvor gemeinsam festlegen müssen, wie Worte geschrieben werden. Dadurch hätten Sie zusammen eine gemeinsame Rechtschreibung erfunden.

Genau wie der Schlüssel zu einem Code, ist Rechtschreibung eine vereinheitlichte Art und Weise, Buchstaben oder andere Schriftzeichen mit den Lauten einer Sprache zu verbinden. Zusammen eine Rechtschreibung zu benutzen, bedeutet dass die Sprecher einer Sprache auch schriftlich miteinander kommunizieren können. Die Form der Zeichen spielt dabei keine große Rolle. Es ist nur wichtig zu verstehen, wie die jeweiligen Zeichen (Grapheme) die Laute, die wir in der Sprache benutzen (Phoneme), darstellen.

Viele Sprachen verwenden zwar die gleichen Schriftzeichen, drücken damit aber verschiedene Laute aus und haben daher auch eine unterschiedliche Rechtschreibung. Sowohl die deutsche als auch die englische Rechtschreibung benutzen Zeichen des lateinischen Alphabetes und beide Sprachen haben viele Graphem-Phonem Übereinstimmungen. Die Relation zwischen dem Buchstaben 'l' und des Lautes 'l' sind im englischen Wort light und im deutschen Wort Licht im Grunde identisch. Allerdings entsprechen die Buchstaben 'th' im Englischen anderen Lauten (z.B. theatre) als im Deutschen (z.B. Theater). Diese Regeln müssen gelernt werden, um die geschriebenen Wortformen richtig aussprechen zu können.

Bei der Frage, was eine gute Rechtschreibung ausmacht gehen die Meinungen auseinander. In der Regel sollten in der Rechtschreibung alle Laute dargestellt werden, die bedeutungsunterscheidend sind. Idealerweise geschieht dies mit so wenig Zeichen und Regelkonventionen wie möglich. Dieser ideale Fall kommt jedoch nur selten vor. Nehmen wir als Beispiel die englische Sprache: Die Worte 'pint' und 'print' unterscheiden sich in ihrer Schreibweise kaum voneinander, werden aber völlig anders ausgesprochen. Kleine Macken und Ungereimtheiten in der Rechtschreibung haben jedoch auch ihre Vorteile. So werden häufig geschichtliche Informationen widergespiegelt, sprach-kulturelle Zusammenhänge verdeutlicht und unterschiedliche Dialekte berücksichtigt.

Lila San Roque & Antje Meyer

Übersetzt von Manu Schütze, Franziska Hartung & Katrin BangelWeiterlesen?

Online encyclopedia of writing systems and languages (link)

The Endangered Alphabets Project (link)

Scriptsource: Writing systems, computers and people (link) - Warum wird auf der Welt soviel Englisch gesprochen?

-